crédits photo Mila Noël

Nous sommes le vendredi 9 décembre 2022 et Monsieur Gaillard, le directeur, a demandé à l'équipe si elle pouvait faire entrer un drone dans son bureau depuis la cour d'honneur de l'institut à l'aide d'un programme que nous coderons en Python. Nous avons accepté le défi et avons réussi à faire entrer le drone dans son bureau. Vous pouvez voir le résultat de cette mission dans la vidéo ci-dessous :

Nous sommes fiers d'avoir réussi à relever ce défi et nous espérons que Monsieur Gaillard a été satisfait de notre travail.

Mais en essayant de relever le défi que nous avions déjà relevé il y avait quelques minutes, le drone s'est malheureusement pris le mur et a chuté de plus de 7 mètres de haut. Heureusement, il va très bien et nous pouvons en tirer une leçon : il n'y a pas que des réussites, il y a aussi des échecs. Cet incident nous rappelle que nous devons toujours être conscients des risques et de la nécessité de prendre les précautions nécessaires. Malheureusement la vidéo de l'incident était de mauvaise qualité, nous avons donc pris la décision de ne pas la publier.

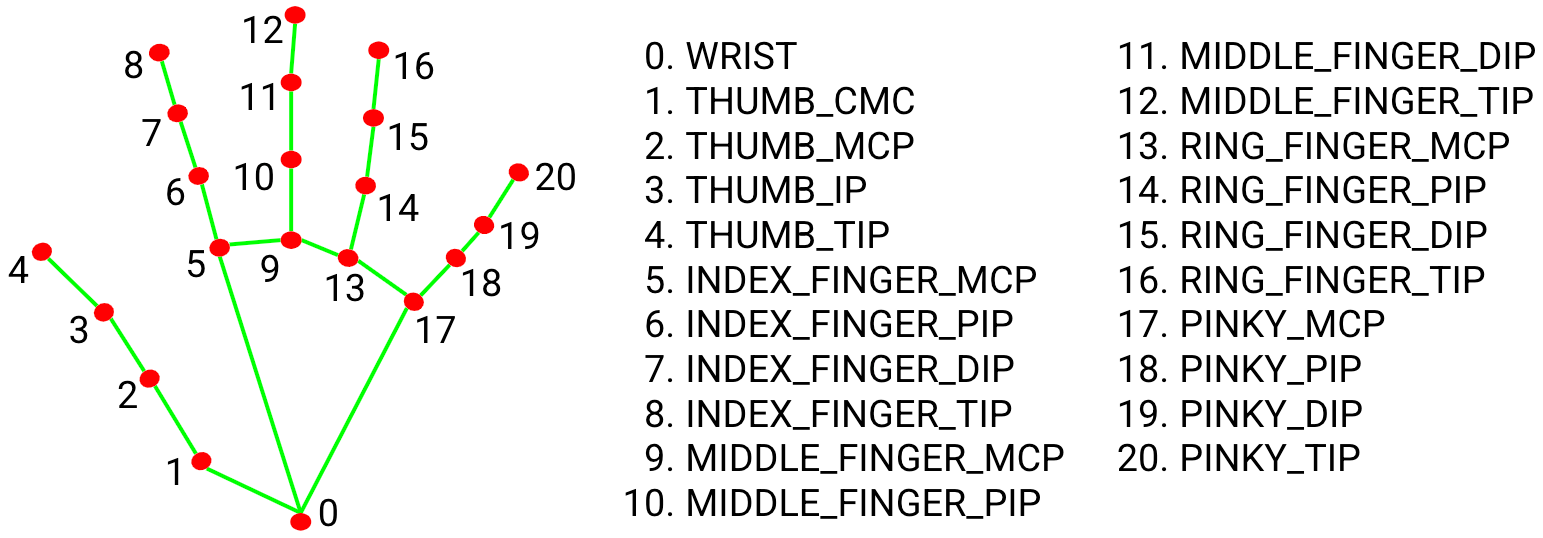

C'est le vendredi 16 décembre 2022 et nous sommes fiers de nous-mêmes. Après avoir relevé le défi de la semaine précédente, nous nous sommes donnés un nouveau défi : contrôler le drone avec nos doigts, ce que nous essayons de faire depuis plusieurs semaines maintenant, et nous l'avons fait ! Afin que le drone puisse analyser l'image de la main, nous utilisons un module qui permet au drone de lire les positions des doigts et des phalanges selon le modèle ci-dessous:

Chaque numéro de point sur la main possède une abscisse et une ordonnée. Selon la position de ces "landmarks", le drone peut en interpréter les variations et executer une commande prédefinie par nos soins.

Nous avons réussi à faire en sorte que si nous montrons 1 doigt au drone, il monte ; si nous lui montrons 2 doigts, il descend ; si nous montrons 3 doigts, il vient vers nous ; si nous montrons 4 doigts, il recule ; et si nous lui montrons 5 doigts, il atterrit. Nous sommes très fiers de ce que nous avons accompli ce vendredi, c'est une grande réussite et un sentiment de satisfaction immense qui nous envahit. Après plusieurs semaines de travail et de dévouement, nous avons réalisé ce que nous voulions juste avant les vacances, c'est une belle façon de se sentir récompensé et de savourer le travail accompli. Nous pouvons maintenant partir en vacances l'esprit tranquille et le cœur léger.

Vous pouvez retrouver le code et la vidéo du travail réalisé en amont avec la webcam ci-dessous.

Nous sommes le vendredi 6 janvier 2023 et nous sommes passés à une nouvelle année. Nous vous souhaitons donc une très bonne année et nous espérons que cette année sera remplie de joie et de bonheur pour vous. Aujourd'hui est le jour de déballage de nos cadeaux et nous sommes très excités. En effet, pour marquer le début de cette nouvelle année l'INJA-Louis Braille nous a fait une très belle surprise. L'Institut nous a offert un drone à chacun pour que nous puissions avancer dans notre progès. Nous sommes très reconnaissants pour ce cadeau et pour tout ce qu'il a fait pour nous. Pour que nous puissions reconnaitre chaque drone et son/sa propriétaire, nous avons décidé de mettre une couleur différente à chaque drone et le nom de son wi-fi sur sa face supérieur. Ainsi, vous pourrez facilement reconnaitre la personne qui contrôle le drone dans les vidéos et les photos.

Liste des dronistes et leur couleur:

C’est l’occasion pour nous de se présenter, ainsi dans les photos suivantes vous verrez chaque élèves et le drone qui lui est associé. Nous sommes sûr que vous trouverez le drone qui vous correspond le mieux. Alors n'hésitez pas à nous rejoindre pour voir ce que nous allons réussir à accomplir avec ces drones et pour partager ce moment avec nous.

crédits photo Mila Noël

Aujourd'hui, c'est le vendredi 13 janvier 2023 et nous avons tous pu tester notre drone! L'objectif de cette séance était de faire une simulation de ce que nous aimerions que le drone réalise. Nous devions faire en sorte que le drone suive notre main lorsque nous lui montrons cinq doigts, car nous n'avons pas encore cherché comment faire pour qu'il suive un individu sans qu'il ait la main levée. Il devait également nous contourner lorsque nous lui montrons trois doigts, ce qui imiterait le repérage d'un obstacle dans son champ de vision. Malheureusement, nous n'avons pas encore parfaitement réussi. Cependant, ce n'est pas une raison pour nous décourager, car nous allons continuer à travailler jusqu'à ce que notre objectif soit atteint. Pour concevoir un drone qui remplacerait un chien guide, la première étape est de développer un système qui permette au drone de suivre le propriétaire. Ce système devrait être capable de détecter le propriétaire et de le suivre où qu'il aille. C'est pourquoi nous n'abandonnerons pas et nous nous efforcerons de réussir à la prochaine séance, ou s'il le faut, à toutes les autres séances à venir. Si vous voulez voir le code utiliser, cliquez sur le bouton ci-dessous.

Aujourd'hui, le vendredi 20 janvier 2023, nous avons réfléchi à plusieurs scénarios car nous devons présenter ce que nous avons réalisé avec le drone à la fin de l'année devant l'ensemble de notre établissement. L'un d'eux consisterait à montrer que nous pouvons contrôler le drone à l'aide de nos mains, ce qui serait très pratique pour lui demander d'effectuer des actions. Pour ce faire, nous avons essayé de transformer notre main en volant et ce n'est pas une blague. Ainsi, en pointant le pouce de notre main droite vers la gauche et en le levant vers le haut, nous pouvons faire aller le drone vers la droite, et en le baissant, le faire aller vers la gauche. Nous sommes parvenus à le faire et vous pouvez le voir dans la vidéo ci-dessous.

Cela n'a pas été un processus simple. En effet, pour parvenir à faire fonctionner le programme il a fallu effectuer des calculs qui manipulent l'axe des abscisses (x) et l'axe des ordonnées (y) sur un plan ainsi que les points clés (les landmarks) des doigts. Nous sommes pour cela très heureux d'avoir réussi. Si vous souhaitez voir le code utilisé, ou l'utiliser avec votre webcam, cliquez sur le bouton ci-dessous.

Aujourd'hui nous sommes le vendredi 27 janvier 2023 et nous avons continué à réfléchi à des scénarios à présenter à la fin de l'année. Notre idée initiale, qui s'inscrit dans la continuité de notre objectif à ce que notre drone repére des obstacles, était que le drone fasse un tour sur lui-même, lorsque nous faisons un signe de la main, pour nous renvoyer tous les obstacles qu'il aurait détecté. Mais comme nous avions réussi à faire en sorte que notre main se transforme en volant dans la séance précédante, nous nous sommes finalement penchés sur la transformation cette fois-ci de la main en levier de marche avant / marche arrière à l'aide de l'index. Pour cela, nous avons essayé d'utiliser le z, qui correspond à la troisième coordonnée d'un plan 3D, mais les valeurs du z variaient trop et cette solution s'est révélée irréalisable. Nous devons donc trouver une autre solution lors de la prochaine séance.

Aujourd'hui, le vendredi 3 février 2023, nous avons réalisé une grande avancée ! Après avoir essayé plusieurs solutions à la problématique de la semaine dernière, nous avons eu une idée: faire en sorte que le drone suive le bout de notre index. Cette idée paraît logique, mais nous ne l'avions pas envisagée et nous n'aurions pas pu la réalisé avant d'avoir manipulé les coordonnées x, y et z. Notre index, qui porte comme landmarks le 8, deviendrait le centre de vision du drone à une distance d'environ 30 cm. Le x permetterait au drone de se déplacer à gauche ou à droite selon le mouvement de l'index. Le y permetterait au drone de monter ou de descendre, encore une fois selon le mouvement de l'index. Et pour finir, le z lui permetterait d'avancer ou de reculer selon le mouvement de l'index. Nous avons commencé à coder cela et les résultats sont pour l'instant très satisfaisants. Nous vous invitons donc à revenir la semaine prochaine car nous sommes motivés à terminer ce programme pour vous présenter le résultat.

Bonjour ! Ce vendredi 10 février 2023, nous avons beaucoup à raconter. Lundi dernier, des étudiants de l'ENSAD (École Nationale Supérieure des Arts Décoratifs) missionnés par l'INJA sont venus à l'Institut pour améliorer certains espaces. En discutant avec eux, nous en sommes venu à leur présenter notre projet drone et ils ont montré un grand intérêt pour le voir en action. Pour cela, nous leur avons proposé une démonstration le lundi 13 février. Nous leur montrerons comment nous parvenons à contrôler le drone à l'aide de nos doigts et comment il est capable de reconnaître des objets. Rappelez-vous nous avions évoqué lors des séances précédentes l'idée de faire faire un tour de 360 degrés au drone lorsque nous faisons un signe de la main, afin qu'il nous renvoie tous les obstacles qu'il détecte. Malheureusement, il est compliqué d'effectuer cette commande avec la fonction que nous utilisons car il faudrait calculer le temps de rotation avec une vitesse donnée et être très précis pour ne pas dépasser d'un degré. Nous avons donc décidé d'étudier comment reconnaître des objets avec Python et nous sommes parvenus à le faire avec des éléments basiques (humain, cravate, stylo, téléphone, ordinateur, sac, certains animaux, pomme, banane, etc.). Les tests effectués avec le drone ont été très concluants. Nous sommes donc très impatients de voir ce que les étudiants de l'ENSAD penseront de notre travail et de notre projet. Cette expérience nous aidera à améliorer ce dernier et à aller plus loin, car c'est la première fois que nous obtiendrons des avis extérieurs à l'Institut.

Aujourd'hui, le vendredi 17 février 2023, nous avons encore une fois beaucoup de choses à partager. En effet, notre démonstration de lundi a été un véritable succès! Tout s'est déroulé à merveille, les étudiants étaient impressionnés, posaient des questions et nous ont donné des conseils. Après discussion avec l'équipe, nous avons eu l'idée de faire en sorte que le drone nous suive sans avoir à lui montrer un objet. Pour cela, nous allons chacun choisir un animal que nous imprimerons pour le coller sur nous. Cette idée peut sembler délirante, mais en attendant de trouver une manière de faire en sorte qu'il suive un individu spécifique, c'est la meilleure solution possible. Car en effet, si le drone est chargé de suivre un être humain, il ne sait pas comment réagir s'il en repère un autre dans son champ de vision, ce qui est très problématique. Nous avons donc testé quels étaient les annimaux que le programme reconnaissait le mieux et finalement le chat, le chien, la girafe et l'éléphant étaient les meilleurs reconnus par le drone. Nous avons donc imprimé des feuilles avec ces animaux et nous avons testées notre idée aujourd'hui. Notre idée a fonctionné à merveille : le drone est capable de nous suivre en gardant une certaine distance avec nous, s'arrêtant lorsque nous nous arrêtons. Nous avons également constaté que le drone reconnaissait très bien les voitures à très longue distance. Notre objectif pour après les vacances est donc de le faire nous suivre et de nous signaler la présence de voitures dans son champ de vision lorsqu'il en verra une.

Aujourd'hui, le vendredi 10 janvier 2023, nous avons eu le privilège de travailler dans la magnifique salle André Marchal de l'institut. Chaque membre de l'équipe a été assigné à un rôle : Mahmoud devait filmer les essais vus de haut avec un drone, Laure devait filmer vus de terre, Anatoli servait de cobaye pour le drone, et Hugo étaient les codeurs pour les programmes du drone, et M. Huyet-Blau, notre professeur, exécuterait les programmes et dirigerait les opérations. L'objectif de cette séance était de progresser dans la façon dont le drone peut suivre un humain, prendre de belles photos et vidéos pour le site et tester un deuxième drone pour filmer le drone en action. Nous avons réussi à faire en sorte que le drone suive correctement Anatoli lorsqu'il avance et recule, et à s'arrêter lorsque Anatoli s'arrête. Vous pouvez même voir dans les vidéos suivantes qu'il a réussi à atterrir sur le piano de la salle. Cette séance a été très concluante, l'équipe est fière de cette réussite et notre objectif pour la prochaine séance est que le drone puisse suivre un humain dans tous ses déplacements, y compris lorsqu'il tourne.

Ce vendredi 17 mars 2023, nous avons atteint un objectif bien plus ambitieux que celui que nous nous étions fixé la semaine précédente : faire en sorte que le drone nous suive dans tous nos déplacements. Nous avons tout d'abord débuté la séance en programmant le drone pour qu'il nous alerte lorsqu'il détecte un obstacle, comme une chaise par exemple, à une certaine distance de nous, et nous informe lorsque nous l'avons dépassé, ce que nous avons remarquablement réussi ! Ensuite, nous avons conçu un algorithme qui permet au drone de pivoter dès que nous nous situons à l'extrême droite ou à l'extrême gauche de sa caméra, afin que nous restions au centre de sa vision. Cet algorithme permet donc au drone de nous suivre dans n'importe lequel de nos déplacements. Grâce à cet algorithme, nous pouvons également atteindre l'un de nos objectifs que nous nous étions fixés : lorsque nous faisons un signe de la main, le drone commence à tourner jusqu'à ce que nous revenions au centre de son champ de vision, pour nous renvoyer tous les obstacles qu'il a détectés. Cependant, lorsqu'un autre humain entre dans son champ de vision, il ne sait plus lequel suivre et cela nous a amenés à imaginer une solution provisoire. Elle consiste à lui assigner une variable dès qu'il repère un humain et à cesser de détecter les autres. Nous allons bientôt tester cette solution et nous vous invitons à revenir vendredi prochain pour savoir si elle a fonctionné. En attendant, vous pouvez regarder les vidéos des tests effectués ce vendredi qui ont été très concluants.

Nous avons adopté la salle André Marchal pour notre laboratoire d’expériences aéronautiques. La salle est très haute de plafond ce qui est très pratique car notre EyeDrone a une autonomie de 10 minutes ce qui permet de le faire voler à des altitudes élevées. Aujourd’hui nous voulons tester la reconnaissance d’objet dans un environnement clos. C’est un succès, le drone a reconnu les chaises, et le piano qu’il a identifié comme … une dining table! La reconnaissance n’est pas extrêmement précise, mais elle permet des multiples possibilités que nous avons hâte d’essayer la prochaine séance.

Nous nous sommes retrouvés pour essayer de travailler sur le repère en trois dimensions fixé par les reconnaissances d’objets. Chaque objet détecté possède une abscisse x et une ordonnée y. Ainsi, il est aisé d’instruire des commandes en Python pour que l’EyeDrone nous obéisse. Une personne déficiente visuelle a besoin d’être suivie par son drone compagnon. Notre idée est d’implémenter un drone capable de nous suivre. Une fois la personne reconnue, les coordonnées sont affichées, et si les variations sont positives ou négatives, le drone réalise le chemin inverse, ce qui simule un suivi. Grâce à notre idée précise de représentation spatiale et à nos connaissances en mathématiques, nos expériences ont été très satisfaisantes pour cette séance, avec un début de suivi assez encourageant.

Nos expériences passées nous amènent à penser à des réalisations concrètes de la reconnaissance d’objets jumelée à l’analyse de leurs coordonnées. Notre idée majeure : protéger l’utilisateur déficient visuel dans un milieu urbain. Le drone reconnaît les voitures et peut suivre une personne (depuis le 14 avril, voir ci-dessus). Nous souhaitons que le drone puisse avertir l’utilisateur de la présence d’une voiture. Ce qui complique les algorithmes, ce sont les différentes positions d’une voiture : stationnement, vitesse élevée, présence d’un feu rouge, etc. Nous avons passé toute la séance à essayer de décortiquer toutes les possibilités, d’autant plus qu’il nous faut trouver des avertissements bien clairs. Heureusement, le module pyttsx3 est bien pratique et permet à Python de générer des sons depuis l’ordinateur. Nous avons hâte d’essayer tous nos algorithmes en situation réelle.

Nous avons travaillé tout le week-end, ce qui est très satisfaisant car nous avons le temps de travailler en profondeur et d'améliorer nos algorithmes. Nous nous sommes concentrés sur la détection de voitures. À l'aide de cv2, le drone peut reconnaître une voiture et un utilisateur, et nous pouvons manipuler leurs coordonnées. Ainsi, lorsque l'abscisse de la voiture est à gauche de l'utilisateur, le drone lance une alerte vocale. Pour les différentes positions de l'utilisateur et de la voiture, nous avons créé différents types d'alertes. Il n'a pas été simple d'écrire un script qui prend en compte le fait que la voiture est stationnée. Le week-end nous a permis de travailler comme dans un open space, ce qui a ajouté beaucoup de convivialité à nos échanges. Vous pouvez voir ci-dessous dans la vidéo le résultat du travail d'un week-end.

L’année se termine déjà, et nous sommes partis avec nos drones en vacances. Nous remercions l’INJA de nous les avoir prêtés, en espérant ne pas les perdre… Cette année a été riche en aventures numériques et spatiales. Nous avons hâte de continuer à coder dès septembre prochain, car il nous reste plein de champs à explorer, comme la reconnaissance vocale et la lecture de panneaux de signalisation… Nous vous souhaitons de bonnes vacances !

Chose promise, chose due, joie de la rentrée scolaire et nous voici à peine de retour de vacances en train de coder notre EyeDrone préféré. Bonne nouvelle, aucun drone égaré pendant les vacances ! Aujourd’hui, nous visons d’utiliser la reconnaissance vocale. Le point technique difficile est que cela utilise le module speech_recognition et de facto les ressources d’internet… Comment se connecter à l’EyeDrone si on doit être connecté à internet en même temps ? Jamais à court d’idée, on s’est dit qu’on pouvait passer par une connexion via notre smartphone. Et ça marche ! Les algorithmes étaient simples, comme obéir à la commande « décollage », à laquelle l’instruction drone.takeoff() de Python prend le relais. Finalement, la difficulté consiste à bien prononcer le mot choisi. Ainsi, nous avons pu instruire les commandes « atterrissage », « avance de un mètre », etc. Un vendredi bien fructueux et sonore !

Aujourd’hui, l’INJA Louis Braille accueille des visiteurs de toute la France dans le cadred des Journées Européennes du Patrimoine. L’institut présente à travers différents ateliers tout ce qui est mis en place pour aider les élèves en situation de handicap visuel. Atelier braille, atelier carte tactile, atelier locomotion, atelier de la vie journalière, et évidemment, nous nous sommes glissés dans la brèche pour présenter notre EyeDrone dans un atelier numérique. Nous avons reçu la visite de nombreuses personnes de l’extérieur, à qui nous avons pu montrer notre travail : des professeurs, des chercheurs, des associations comme ApiDV, et toutes les personnes à Paris qui passaient par là. Nous étions dans la gymnase avec un écran géant, et nous pouvions présenter en direct le code et l’action sur l’EyeDrone. Ce format a beaucoup plu. Et là, coup de tonnerre, nous sommes invités à présenter nos travaux par l’association « Voir Ensemble » lors d’une conférence internationale se déroulant à Moulins dans l’Allier le 30 novembre ! Nous avons immédiatement accepté, ne sachant pas quel défi nous allions devoir relever !

Nous avons discuté des nouveaux champs d’investigation que l’on pourrait présenter lors de la conférence à Moulins, le 30 novembre 2024. De tout ce que nous avons déjà réalisé, il nous reste un point à approfondir : l’EyeDrone doit pouvoir lire du texte. Nous cherchons sur internet et il semble que le module Tesseract puisse répondre à nos attentes…

Le module Tesseract fonctionne à merveille, mais l’EyeDrone semble avoir des difficultés à se fixer sur le texte. Pour l’instant, la webcam fait l’affaire.

En approfondissant les possibilités de Tesseract, l’EyeDrone est en mesure de lire du texte, mais le déchiffrage est confus. D’autre part, il semble difficile de combiner les codes précédents avec Tesseract. L’EyeDrone ne semble pas assez puissant pour traiter toutes les informations qu’il reçoit entre tous les modules utilisés. À la conférence, nous allons sécuriser les fonctionnalités existantes que nous avons déjà créées, c’est plus sûr…>Le module Tesseract fonctionne à merveille, mais l’EyeDrone semble avoir des difficultés à se fixer sur le texte. Pour l’instant, la webcam fait l’affaire.

Nous utilisons cette séance pour créer une présentation diaporama de ce que nous allons présenter jeudi prochain. Laure et Anatoli se chargent de la présentation, tandis que Mahmoud et Hugo peaufinent les derniers ajustements de l’EyeDrone. Il y aura au menu : reconnaissance d’objets, reconnaissance digitale, reconnaissance vocale, reconnaissance du texte, et diffusion d’une vidéo des travaux réalisés lors du week-end NSI. Pour être honnête, la pression monte !

Au début du mois de septembre 2023, lors des Journées Européennes du Patrimoine, nous avons fièrement présenté l'ensemble de nos récents travaux dédiés à l'EyeDrone. Cette journée s'est révélée exceptionnelle, attirant de nombreux visiteurs à l'Institut en ce samedi 16 septembre, parmi lesquels figurait l'association Voir Ensemble.

À notre grande joie, cette association nous a généreusement conviés à une conférence à Moulins le 1er décembre 2023 pour partager nos avancées. Au cours des trois mois suivants, notre objectif principal était de réaliser une présentation professionnelle. À cet effet, nous avons élaboré un plan d'action axé sur la mise en avant de quatre grandes fonctionnalités : le Hand Control, l'Object Recognition, le Voice Control, ainsi que la reconnaissance de texte via l'OCR (Optical Character Recognition).

La veille de l'événement, nous nous sommes rendus à Moulins en utilisant l'INJA-mobile, parcourant ainsi quatre heures de route pour enfin arriver à destination. Nous avons loué une superbe demeure où nous avons préparé de délicieux plats tout en peaufinant les détails de notre conférence. Après quelques ajustements de dernière minute, nous étions enfin prêts.

La conférence s'est déroulée de manière exemplaire, récoltant des applaudissements et des félicitations de l'ensemble des participants. Nous avons souligné avec insistance que l'EyeDrone trouve son intérêt dans l'accompagnement des déficients visuels dans toutes les situations où ils nécessitent une assistance. À cette fin, nous développons des codes répondant spécifiquement à nos besoins en matière de robotique.

Cette conférence nous a également offert une opportunité exceptionnelle, celle d'être interviewés par la radio locale RCF, et nous a permis d'établir le contact avec un membre du CNRS qui nous a aimablement proposé un stage.

Nous vous faisons parvenir ci-dessous des photos de cette remarquable épopée :